🔍 Introducción

Azure Synapse Analytics se ha consolidado como una plataforma integral de análisis en la nube, combinando herramientas de data warehousing, big data, ETL/ELT, y machine learning en un único entorno. En 2025, evoluciona hacia una solución aún más eficiente, escalable y alineada con tecnologías emergentes como IA y arquitecturas sin servidor.

Azure Synapse Analytics es una solución desarrollada por Microsoft que permite a empresas y organizaciones manejar, transformar y analizar enormes volúmenes de datos desde una sola plataforma. En lugar de depender de herramientas separadas para cargar, procesar y visualizar información, Synapse unifica todo en un mismo entorno. Esto facilita una toma de decisiones más rápida y fundamentada.

Una plataforma todo en uno para el análisis de datos

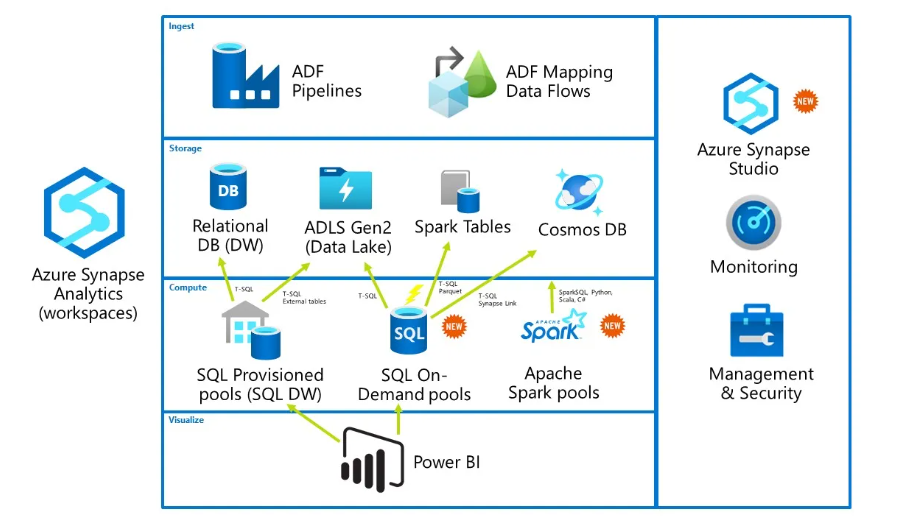

Azure Synapse combina capacidades de almacenamiento de datos empresariales (conocido como data warehousing) con herramientas de análisis masivo como Apache Spark. Así, permite trabajar tanto con datos estructurados como no estructurados, sin necesidad de moverlos de un sistema a otro.

Con esta plataforma, los usuarios pueden escribir consultas en SQL, programar flujos de trabajo de integración de datos (ETL), ejecutar algoritmos de inteligencia artificial, y visualizar resultados directamente mediante Power BI, todo dentro del mismo espacio de trabajo.

1. Integración total y analítica en tiempo real

- Unificación de capacidades: Synapse ofrece una experiencia integrada que abarca almacenamiento, computación SQL (dedicado y serverless), Spark, pipelines y visualización con Power BI.

- Analítica inmediata: Su integración con Azure Stream Analytics y Spark permite tratar datos en tiempo real, facilitando dashboards actualizados instantáneamente

| Característica | Beneficio |

|---|---|

| Plataforma unificada | No es necesario cambiar de herramienta para cada tarea. |

| Escalabilidad | Maneja desde pequeños conjuntos hasta petabytes de datos. |

| Análisis en tiempo real | Permite respuestas inmediatas ante eventos de negocio. |

| Bajo costo operativo | Solo se paga por lo que se utiliza. |

| Seguridad avanzada | Protección granular y cumplimiento regulatorio. |

2. 🔧 Funciones principales de Azure Synapse Analytics

Azure Synapse es mucho más que un data warehouse. Es una plataforma todo-en-uno para:

| Función | Descripción |

|---|---|

| Ingesta de datos | Permite capturar datos desde diversas fuentes (bases SQL, NoSQL, archivos, APIs, servicios en la nube, etc.) usando pipelines. |

| Transformación (ETL/ELT) | Facilita la limpieza, transformación y carga de datos en entornos estructurados o semiestructurados. |

| Consulta analítica | Ejecuta consultas sobre grandes volúmenes de datos, optimizadas por motores paralelos. |

| Análisis avanzado | Admite modelos de Machine Learning e Inteligencia Artificial, tanto en SQL como Spark. |

| Visualización | Se integra nativamente con Power BI para crear dashboards directamente desde los datos. |

| Seguridad y gobernanza | Asegura la privacidad de los datos con cifrado, control de accesos, y linaje de datos mediante integración con Microsoft Purview. |

Imagen tomada de: Serra, James. “SQL on-demand in Azure Synapse Analytics.” James Serra’s Blog, August 24, 2020. https://www.jamesserra.com/archive/2020/08/sql-on-demand-in-azure-synapse-analytics/.

🔍 Tipos de motores de procesamiento (pools) en Azure Synapse Analytics

Azure Synapse proporciona distintos entornos de ejecución llamados pools, los cuales se adaptan a diferentes necesidades analíticas. A continuación, se explican sus características, casos de uso y ejemplos prácticos.

a) SQL Dedicated Pool (anteriormente conocido como SQL Data Warehouse)

🔹 Descripción: Este motor está diseñado para manejar operaciones SQL a gran escala utilizando procesamiento paralelo masivo (Massively Parallel Processing, MPP).

🔹 Uso recomendado: Ideal para empresas que requieren cargar y analizar grandes volúmenes de datos estructurados, como en escenarios de inteligencia de negocios y almacenes de datos corporativos.

🔹 Cómo funciona: La información se divide automáticamente en múltiples fragmentos que se procesan en paralelo a través de unidades distribuidas, optimizando así el tiempo de respuesta.

🔹 Modelo de cobro: Se factura con base en la capacidad que se provisiona mediante unidades conocidas como Data Warehousing Units (DWUs).

🔹 Ejemplo práctico: Analizar más de 500 millones de registros mediante una consulta que cruza múltiples tablas de gran tamaño.

b) Serverless SQL Pool

🔹 Descripción: Este motor permite ejecutar consultas SQL de forma ad hoc sin necesidad de configurar infraestructura previa. Es totalmente elástico y bajo demanda.

🔹 Uso recomendado: Perfecto para análisis rápidos o exploratorios sobre archivos en bruto alojados en Azure Data Lake.

🔹 Cómo funciona: Las consultas se ejecutan directamente sobre archivos como CSV, Parquet o JSON, eliminando la necesidad de importar datos a una base de datos formal.

🔹 Modelo de cobro: El costo se basa exclusivamente en la cantidad de datos procesados por cada consulta, medidos en terabytes (TB).

🔹 Ejemplo práctico: Leer y analizar solo 10 columnas de un archivo Parquet de 2 TB sin necesidad de cargarlo previamente a una tabla.

c) Apache Spark Pool

🔹 Descripción: Motor que utiliza Apache Spark para realizar procesamiento distribuido en memoria, ideal para flujos de datos complejos y tareas de aprendizaje automático.

🔹 Uso recomendado: Muy útil para científicos de datos, ingenieros de machine learning y analistas que trabajan con grandes volúmenes de datos no estructurados o semiestructurados.

🔹 Cómo funciona: Se generan clústeres de Spark temporales que pueden escalar según la carga de trabajo, permitiendo realizar transformaciones avanzadas o entrenar modelos predictivos.

🔹 Modelo de cobro: Depende del tamaño y tiempo de uso de los nodos que conforman el clúster.

🔹 Ejemplo práctico: Entrenar un modelo de predicción de demanda utilizando PySpark y bibliotecas de ciencia de datos sobre cinco años de registros históricos.

d) Data Explorer Pool (uso opcional)

🔹 Descripción: Motor diseñado para analizar grandes volúmenes de datos de tipo serie temporal o eventos generados por sensores, dispositivos o sistemas de monitoreo.

🔹 Uso recomendado: Ideal para trabajar con telemetría, registros del sistema y escenarios IoT que requieren alta velocidad de consulta.

🔹 Cómo funciona: Utiliza un modelo de indexado columnar y compresión avanzada para optimizar el almacenamiento y acelerar las búsquedas.

🔹 Modelo de cobro: Se calcula en función del almacenamiento utilizado y la cantidad de datos consultados.

🔹 Ejemplo práctico: Detectar comportamientos anómalos en millones de registros generados por sensores durante un periodo de 24 horas.

Quienes adopten Synapse como núcleo de su ecosistema de datos, o la combinen con Microsoft Fabric, ganan en agilidad, economía y capacidad estratégica para convertir datos en ventaja competitiva.